Varför ger HDMI-DVI en skarpare bild än VGA?

Med all den stora hårdvaran som vi har tillgång till idag verkar det som om vi ska njuta av god kvalitetskvalitet oavsett vad, men vad om det inte är fallet? Dagens SuperUser Q & A inlägg försöker rensa saker för en förvirrad läsare.

Dagens Question & Answer-session kommer till oss med tillstånd av SuperUser-en indelning av Stack Exchange, en community-driven gruppering av Q & A-webbplatser.

Foto med tillstånd av lge (Flickr).

Frågan

SuperUser-läsare alkamid vill veta varför det finns en märkbar skillnad i kvalitet mellan HDMI-DVI och VGA:

Jag har en Dell U2312HM-skärm ansluten till en Dell Latitude E7440-bärbar dator. När jag ansluter dem via en bärbar dator -> HDMI-kabel -> HDMI-DVI-adapter -> bildskärm (bildskärmen saknar HDMI-uttag), är bilden mycket skarpare än om jag ansluter via bärbar dator -> miniDisplayPort-VGA-adapter -> VGA kabel -> bildskärm.

Skillnaden är svår att fånga med en kamera, men se mitt försök på det nedan. Jag försökte spela med ljusstyrka, kontrast och skärpa inställningar, men jag kan inte få samma bildkvalitet. Upplösningen är 1920 * 1080 med Ubuntu 14.04 som mitt operativsystem.

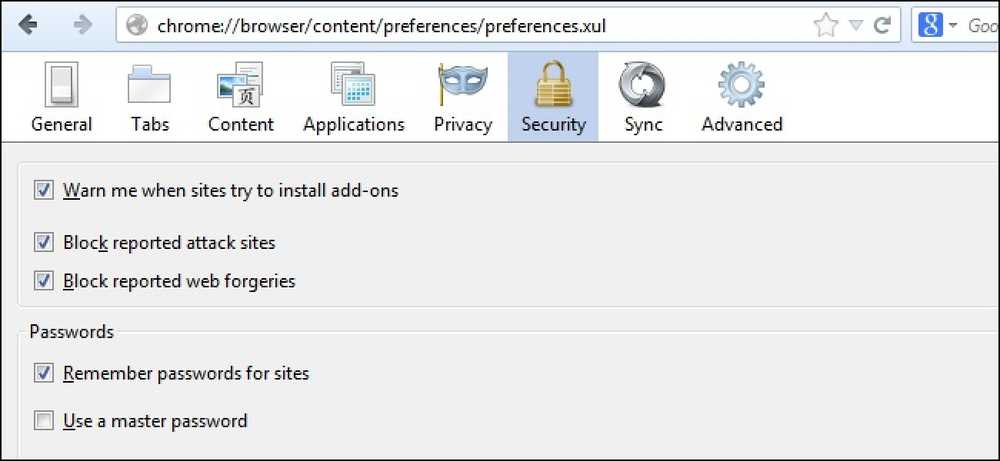

VGA:

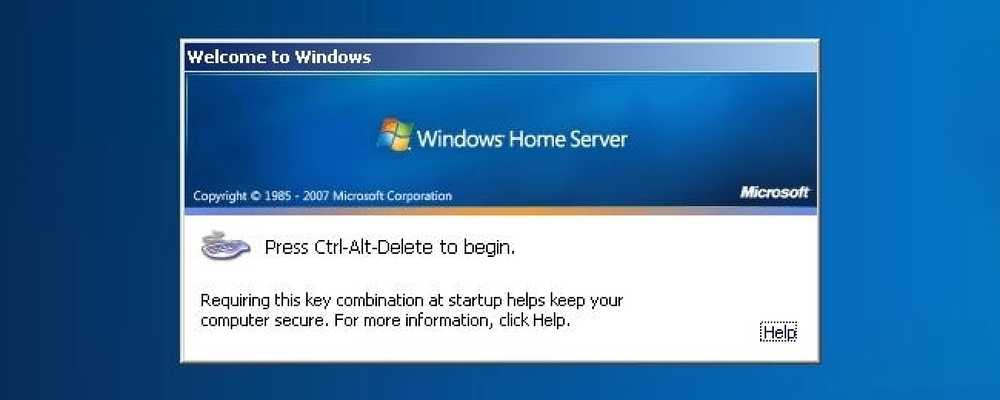

HDMI:

Varför är kvaliteten annorlunda? Är det iboende för dessa standarder? Kan jag få en felaktig VGA-kabel eller mDP-VGA-adapter?

Varför är det en skillnad i kvalitet mellan de två?

Svaret

SuperUser-bidragsgivare Mate Juhasz, Youngwt och Jarrod Christman har svaret för oss. Först upp, Mate Juhasz:

VGA är den enda analoga signalen bland de som nämnts ovan, så det är redan en förklaring till skillnaden. Att använda adaptern kan förvärra kvaliteten ytterligare.

Några ytterligare läsningar: HDMI vs DisplayPort vs DVI vs VGA

Följt av svaret från youngwt:

Om man antar att ljusstyrka, kontrast och skärpa är desamma i båda fallen, kan det finnas två andra anledningar till att texten är skarpare med HDMI-DVI.

Den första har redan sagts, VGA är analog, så det måste gå igenom en analog till digital konvertering inuti bildskärmen. Detta kommer teoretiskt försämra bildkvaliteten.

För det andra, förutsatt att du använder Windows finns en teknik som heter ClearType (utvecklad av Microsoft) vilket förbättrar utseendet på text genom att manipulera subpixlarna på en LCD-skärm. VGA har utvecklats med CRT-skärmar i åtanke och begreppet sub-pixel är inte detsamma. På grund av kravet på ClearType att använda en LCD-skärm och det faktum att VGA-standarden inte berättar för värdens specifikationer på displayen, skulle ClearType avaktiveras med en VGA-anslutning.

Jag kommer ihåg att höra om ClearType från en dess skapare på en podcast för This (). Developers (). Life () IIRC, men denna Wikipedia-artikel stöder också min teori. Även HDMI är bakåtkompatibel med DVI och DVI stödjer elektronisk displayidentifiering (EDID).

Med vårt sista svar från Jarrod Christman:

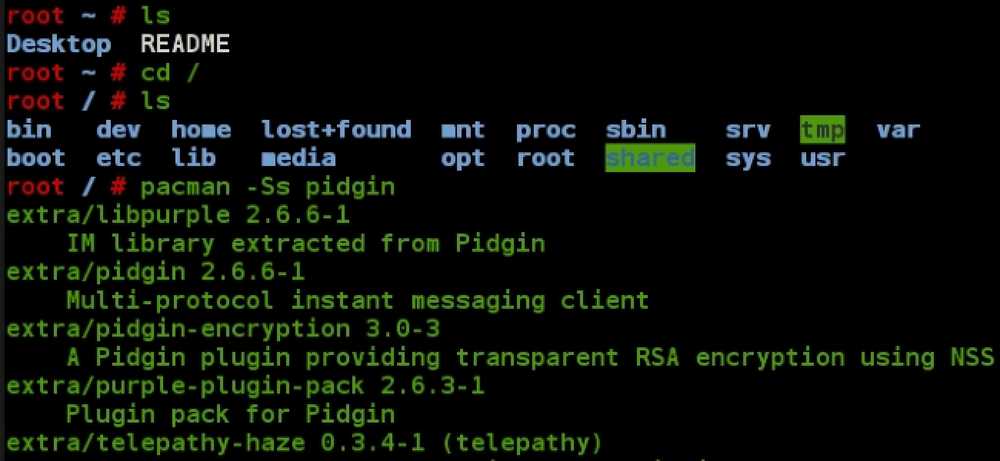

De andra gör några bra poäng, men huvudorsaken är en uppenbar klock- och fasmatchning. VGA är analog och utsatt för störningar och felmatchning av de analoga sändnings- och mottagarsidorna. Normalt skulle man använda ett mönster som detta:

Klocka och fas

Justera sedan klockan och fasen på bildskärmen för att få den bästa matchningen och den skarpaste bilden. Men eftersom det är analogt, kan dessa justeringar övergå över tid, och så borde du helst bara använda en digital signal.

Har du något att lägga till förklaringen? Ljud av i kommentarerna. Vill du läsa mer svar från andra tech-savvy Stack Exchange-användare? Kolla in hela diskussionsgängan här.